του Τζούλιο Nτε Πέτρα*

Από τότε που η έρευνα του Γιουβάλ Άμπρααμ στο ισραηλινό περιοδικό +972 Magazine ανέφερε ότι ο ισραηλινός στρατός χρησιμοποιεί εντατικά στον πόλεμο της Γάζας συστήματα βασισμένα στην τεχνητή νοημοσύνη[1], έχει δοθεί μεγάλη προσοχή από τον Τύπο στη λειτουργία και τη χρήση του «Lavender» (Λεβάντα): αυτό είναι το όνομα του επί τούτου ανεπτυγμένου συστήματος τεχνητής νοημοσύνης. Ειδικότερα, ειδήμονες και εμπειρογνώμονες εντυπωσιάστηκαν από το γεγονός ότι ο προσδιορισμός των προς θανάτωση στόχων ανατέθηκε στην πραγματικότητα σε ένα ψηφιακό σύστημα, χωρίς κανέναν έλεγχο ή παρέμβαση από «ανθρώπινο» στρατιωτικό προσωπικό.

Δεδομένου ότι οι προς θανάτωση στόχοι είναι μαχητές της Χαμάς, προέκυψε το ερώτημα με ποια κριτήρια το σύστημα αναγνωρίζει ποιος είναι μαχητής της Χαμάς, και επίσης πώς αποδίδει στον στόχο έναν βαθμό (αρχηγός, αξιωματικός, οπλίτης, ακροβολιστής). Έναν βαθμό από τον οποίο, όπως θα δούμε, εξαρτώνται πολλά όσον αφορά τις διαδικασίες «εξάλειψης» των στόχων. Ένα δεύτερο ερώτημα αφορά το ποια ήταν τα στοιχεία –που αξιολογούνται και πάλι από το αυτόματο σύστημα– τα οποία συνδέουν τον στόχο που εντοπίστηκε με αυτόν τον τρόπο με ένα πραγματικό σημείο του χάρτη της Γάζας που πρέπει να χτυπηθεί. Επιπλέον, δεδομένου του εκτιμώμενου ποσοστού σφάλματος στο 10% των περιπτώσεων, επικρίθηκε η απουσία οποιουδήποτε ανθρώπινου ελέγχου, ο οποίος θα μείωνε ίσως κατά μερικές ποσοστιαίες μονάδες την πιθανότητα ψευδώς θετικού αποτελέσματος. Δηλαδή να γίνει στόχος κάποιος που δεν είναι μαχητής της Χαμάς.

Το πρόβλημα είναι ότι η σφαγή αμάχων συνιστά προγραμματισμένη επιλογή

Με άλλα λόγια, στην ανάλυση και τον σχολιασμό για την αξιολόγηση αυτού του αυτόματου συστήματος ψηφιακής πρόβλεψης χρησιμοποιήθηκαν τα ίδια επιχειρήματα που θα χρησιμοποιούνταν για μια καμπάνια μάρκετινγκ με σκοπό την πώληση μιας ηλεκτρικής σκούπας. Με τον ίδιο τρόπο που τα αυτόνομα όπλα (τα οποία είναι εδώ και καιρό παρόντα σε πολλά θέατρα πολέμου) αυξάνουν περαιτέρω τον διαχωρισμό μεταξύ αυτών που σκοτώνουν και αυτών που σκοτώνονται, μετατρέποντας τον βομβαρδισμό μιας πόλης σε βιντεοπαιχνίδι, η αφήγηση και ο σχολιασμός σχετικά με τη χρήση της τεχνητής νοημοσύνης στον πόλεμο φαίνεται επίσης να έχει χάσει εντελώς από την οπτική της το πλαίσιο, το νόημα, τις συνέπειες και την ευθύνη.

Τα παραπάνω, στην προκειμένη περίπτωση, δεν αφορούν το ποσοστό των ψευδώς θετικών αποτελεσμάτων του συστήματος αυτόματης πρόβλεψης, αλλά τη συνειδητή και προγραμματισμένη επιλογή του ισραηλινού στρατού να σκοτώνει εκατοντάδες αμάχους, γυναίκες και παιδιά κάθε φορά που προσπαθεί να «εξαλείψει» τον στόχο που έχει εντοπίσει η τεχνητή νοημοσύνη. Οι στόχοι να χτυπιούνται όταν επιστρέφουν στα σπίτια τους, ή όταν κινούνται σε πολυσύχναστα μέρη: αυτό προτείνει η Λεβάντα. Και αν ο βαθμός του στόχου έχει προσδιοριστεί από το αυτόματο σύστημα ταξινόμησης π.χ. ως αρχηγός, η ποσότητα των ανθρώπων που σκοτώνονται προκειμένου να «εξαλειφθεί» μπορεί να είναι τόσο μεγάλη όσο οι εκατοντάδες κάτοικοι μιας ολόκληρης πολυκατοικίας.

Να εξηγεί κανείς με τη χρήση ενός συστήματος τεχνητής νοημοσύνης τις βόμβες των 1.000 κιλών που ρίχνονται σε πληθυσμιακά κέντρα και πυκνοκατοικημένους προσφυγικούς καταυλισμούς μοιάζει περισσότερο με γκροτέσκα δικαιολόγηση μιας σφαγής, παρά με χρήση εξελιγμένων όπλων.

Στην ψηφιοποίηση του πολέμου αντιστοιχεί η στρατιωτικοποίηση των ψηφιακών τεχνολογιών. Η χρήση της τεχνητής νοημοσύνης στον πόλεμο της Γάζας είναι μόνο η κορυφή του παγόβουνου μιας ευρύτερης και εντονότερης πολεμικής στροφής στην ψηφιακή παραγωγή

Ψηφιοποίηση του πολέμου και στρατιωτικοποίηση των ψηφιακών τεχνολογιών

Ωστόσο, το γεγονός ότι η προσοχή των εμπειρογνωμόνων και των διαμορφωτών της κοινής γνώμης στράφηκε στη χρήση της τεχνητής νοημοσύνης στα θέατρα πολέμου είχε το πλεονέκτημα να φέρει στην επιφάνεια αυτό που ήδη συμβαίνει εδώ και πολλά χρόνια στις στρατηγικές ανάπτυξης των μεγάλων ψηφιακών μονοπωλίων: μια αυξανόμενη και αμοιβαία εξάρτηση μεταξύ της ψηφιακής βιομηχανίας και του κρατικού στρατιωτικού μηχανισμού. Ο στρατιωτικός μηχανισμός εξαρτάται όλο και περισσότερο από τα προϊόντα και τις υπηρεσίες των ψηφιακών εταιρειών σε όλα τα θέατρα πολέμου, και οι μεγάλες εταιρείες τεχνολογίας αναζητούν όλο και περισσότερο νέες αγορές, προσοδοφόρα κυβερνητικά συμβόλαια ή επενδύσεις σε έρευνα και ανάπτυξη που προσανατολίζεται σε στρατιωτική χρήση.

Για να καταδειχθεί η αυξανόμενη χρήση της ψηφιακής τεχνολογίας στη στρατιωτική σφαίρα, δεν υπάρχει μόνο η έρευνα του περιοδικού +972 Magazine για τη Λεβάντα. Αρκεί να θυμηθούμε τον ρόλο που έπαιξε και παίζει το Starlink, το δίκτυο που ανήκει στον Ίλον Μασκ, στον πόλεμο στην Ουκρανία. Ή την εκθετική αύξηση της παραγωγής στρατιωτικών μη επανδρωμένων αεροσκαφών και των ψηφιακών εξαρτημάτων τους, από την Ουκρανία ως τη Ρωσία, από το Ιράν ως την Τουρκία και, τέλος, από την ιταλική πολεμική βιομηχανία Leonardo.

Και αντιστρόφως, για να καταδειχθεί η εξάρτηση των μεγάλων επιχειρήσεων από τις δημόσιες συμβάσεις στρατιωτικού χαρακτήρα, αρκεί να ανατρέξουμε σε πρόσφατη έρευνα, η οποία περιγράφει τις πολυάριθμες μεγάλες δημόσιες συμβάσεις της Big Tech των ΗΠΑ[2]. Αυτή η στροφή της ψηφιακής βιομηχανίας προς τη στρατιωτική παραγωγή έχει τόσο ισχυρή επιτάχυνση στους δύο σημερινούς πολέμους, ώστε αποτελεί από μόνη της έναν από τους λόγους που καθορίζουν τη συνέχιση των συγκρούσεων, αλλά και τη μελλοντική τους πορεία.

Συμβαίνει στη Γάζα

Το ιαπωνικό ειδησεογραφικό πρακτορείο Nikkei αναφέρει, για παράδειγμα, πως αρκετές ισραηλινές νεοφυείς επιχειρήσεις εξάγουν προηγμένη στρατιωτική τεχνολογία που τροφοδοτείται από τεχνητή νοημοσύνη, η ακρίβεια της οποίας έχει βελτιωθεί ακριβώς λόγω της χρήσης της στον πόλεμο της Γάζας:

- Π.χ. η Axon Vision ισχυρίζεται ότι το σύστημά της Edge 360, το οποίο είναι εγκατεστημένο σε τεθωρακισμένα οχήματα που αναπτύσσονται σήμερα στη Γάζα, αναγνωρίζει απειλές από όλες τις κατευθύνσεις, και ειδοποιεί τον στρατιώτη που οδηγεί το όχημα. Ο διευθύνων σύμβουλος Ρόι Ρίφτιν σε συνέντευξή του περιγράφει τα οφέλη της στενής σχέσης με τον ισραηλινό στρατό: «Λαμβάνουμε συνεχώς feedback».

- Η Asio Technologies δοκιμάζει για πρώτη φορά στη Γάζα το σύστημα Orion, το οποίο προσδιορίζει την απόσταση και τη θέση ενός στόχου χρησιμοποιώντας γεωγραφικά δεδομένα και εναέρια πλάνα. Τα αποτελέσματα παρέχουν στους στρατιώτες διαδρομές προσέγγισης ενός στόχου που ελαχιστοποιούν τις εχθρικές γραμμές πυρός.

- Η SmartShooter είναι μια αναδυόμενη τεχνολογική εταιρεία που παρέχει έξυπνο εξοπλισμό ελέγχου πυρός για τυφέκια, ώστε να διασφαλίζεται ακριβέστερη βολή. Το BBC αναφέρει ότι, μετά από τις δοκιμές στη Γάζα, οι Βρετανοί στρατιώτες εκπαιδεύονται επίσης χρησιμοποιώντας εξοπλισμό που παράγεται από την SmartShooter.

Συμβαίνει στην Ουκρανία

Αυτό που έχει ξεκινήσει η ουκρανική κυβέρνηση δεν διαφέρει, και περιγράφεται σε άρθρο του Φλάβιο Πινταρέλι[3]. Στις 26/4/2023, χάρη στη συνεργασία έξι σημαντικών ουκρανικών θεσμικών φορέων που δραστηριοποιούνται στον τομέα της ασφάλειας και της άμυνας (των Yπουργείων Ψηφιακού Μετασχηματισμού, Στρατηγικών Βιομηχανιών, Οικονομίας και Άμυνας, του Γενικού Επιτελείου των Ουκρανικών Ενόπλων Δυνάμεων και του Εθνικού Συμβουλίου Ασφαλείας και Άμυνας), ιδρύθηκε το BRAVE1, μια πλατφόρμα για την επιτάχυνση της ανάπτυξης του τεχνολογικού οικοσυστήματος στον αμυντικό τομέα και την επιτάχυνση της ανάπτυξης συστημάτων έτοιμων για χρήση στην πρώτη γραμμή:

- «Αποστολή μας», γράφει η Νατάλια Κουσνέρσκα στο έγγραφο παρουσίασης του BRAVE1, «είναι να προωθήσουμε τη συνεργασία μεταξύ των διαφόρων φορέων που εμπλέκονται στη διαδικασία: εταιρείες, δυνάμεις ασφαλείας και άμυνας, κυβέρνηση, βιομηχανία, επενδυτές, ιδρύματα, διεθνείς εταίροι, μέσα ενημέρωσης και κάθε άλλος φορέας που εμπλέκεται στην ενίσχυση των δυνατοτήτων των ουκρανικών ενόπλων δυνάμεων. Για το σκοπό αυτό, το BRAVE1 προσελκύει και υποστηρίζει τους προγραμματιστές και τους καινοτόμους στον τομέα των αμυντικών τεχνολογιών, και επιταχύνει την εφαρμογή των προϊόντων παρέχοντας πρόσβαση σε στρατιωτική εμπειρογνωμοσύνη, δυνατότητες επίδειξης και δοκιμών, και χρήσης σε επιχειρησιακό περιβάλλον».

- Για την ουκρανική κυβέρνηση, η τεχνολογία άμυνας και ασφάλειας δεν είναι ένα όραμα που περιορίζεται αποκλειστικά στην άμυνα, αλλά αποτελεί μέρος ενός στρατηγικού σχεδίου με στόχο να καταστεί η Ουκρανία παγκόσμιος κόμβος στον τομέα της αμυντικής τεχνολογίας. Το όραμα αυτό επιβεβαιώνεται από τον ίδιο τον πρόεδρο Ζελένσκι, ο οποίος, σε συνέντευξή του στη δημοσιογράφο Νατάλια Μοσεϊτσούκ, τονίζει πως η Ουκρανία έχει, τόσο στη γεωργία όσο και στην τεχνολογία, μεγάλες ευκαιρίες – συμπεριλαμβανομένης και της ευκαιρίας να γίνει ηγετική χώρα στον τομέα της άμυνας και της ασφάλειας. Σε αυτό το όραμα, οι μικρές νεοφυείς επιχειρήσεις που σήμερα ασχολούνται με την επινόηση, την ανάπτυξη, τη δοκιμή και τη βελτιστοποίηση νέων πολεμικών τεχνολογιών, φιλοδοξούν να γίνουν, τα επόμενα χρόνια, ισχυρές τεχνολογικές εταιρείες στον αμυντικό τομέα, αξίας δισεκατομμυρίων δολαρίων και ικανές να φέρουν στην αγορά λύσεις που έχουν ήδη δοκιμαστεί στο πεδίο της μάχης.

Διπλή χρήση

Τα παραδείγματα αυτά, τα οποία δείχνουν πώς ένα πραγματικό θέατρο πολέμου μπορεί να αποτελέσει το καλύτερο δυνατό περιβάλλον δοκιμών για τις ψηφιακές εταιρείες που παράγουν στρατιωτικές τεχνολογίες, αποκαλύπτουν επίσης τις συνέπειες της φράσης «διπλή χρήση», η οποία –στις προθέσεις αυτών που τη χρησιμοποιούν– περιγράφει το γεγονός ότι μια τεχνολογία ή ένα πεδίο τεχνολογικής έρευνας μπορεί να έχει διπλή πιθανή χρήση: τόσο στον στρατιωτικό όσο και στον πολιτικό τομέα. Και ότι αυτή η διπλή πιθανή χρήση δικαιολογεί και επιτρέπει την έρευνα, ακόμη και σε πανεπιστημιακό επίπεδο, σε τομείς εφαρμογής που μπορούν να αξιοποιηθούν στον στρατιωτικό τομέα. Αν αναφερθούμε στη Λεβάντα, δηλαδή στη χρήση συστημάτων τεχνητής νοημοσύνης που βασίζονται στη μηχανική μάθηση για τον εντοπισμό στόχων που πρέπει να χτυπηθούν, η συνέπεια είναι αυτή που περιγράφει αποτελεσματικά η Ντανιέλα Ταφάνι σε μια εργασία που δημοσιεύθηκε στο Orizzonti, το διαδικτυακό τμήμα του περιοδικού Italiani Europei:

«Η ανάπτυξη των συστημάτων μηχανικής μάθησης πραγματοποιείται στο πλαίσιο μιας σχέσης, αρχικής και συστατικής, με τον στρατιωτικό μηχανισμό και τα κρατικά συστήματα επιτήρησης: τα πρώτα συστήματα μηχανικής όρασης κατασκευάστηκαν για την αυτοματοποίηση της φωτοερμηνείας αεροφωτογραφιών, την αναζήτηση αντικειμένων στρατιωτικού ενδιαφέροντος και την αλυσίδα επιτήρησης… Η έκφραση αυτής της σχέσης με την όρο “διπλή χρήση” είναι παραπλανητική: τα συστήματα που σχεδιάζονται για στρατιωτικούς σκοπούς διατηρούν το αρχικό περιβάλλον, την εννοιολόγηση των αντικειμένων ενδιαφέροντος, τις κανονιστικές παραδοχές και τη λογική. Με την προληπτική αστυνόμευση, για παράδειγμα, το σύνολο των πολιτών μετατρέπεται σε πρόσωπα που υπόκεινται σε επιτήρηση, επεκτείνοντας τη στρατιωτική λογική των πληροφοριών στην πολιτική σφαίρα και καταστέλλοντας το δικαίωμα του ατόμου να μην αποτελεί αντικείμενο επιτήρησης χωρίς βάσιμο λόγο».

* Ο Τζούλιο Ντε Πέτρα είναι ειδικός στην ψηφιακή καινοτομία στις δημόσιες διοικήσεις. Διετέλεσε μεταξύ άλλων διευθυντής της ιταλικής Αρχής για την Πληροφορική στη Δημόσια Διοίκηση (AIPA) και του Εθνικού Κέντρου Καινοτομίας της Δημόσιας Διοίκησης (CNIPA). Είναι μέλος του Δ.Σ. του Ιδρύματος Astrid, συνεργάτης του Πολυτεχνείου του Τορίνο και διευθυντής του Κέντρου για την Κρατική Μεταρρύθμιση (CRS). Στην ιστοσελίδα του τελευταίου (centroriformastato.it) δημοσιεύθηκε, στις 19/4/2024, το παρόν άρθρο. Ο τίτλος SoftWar είναι παράφραση του αγγλικού όρου software (λογισμικό υπολογιστών), και θα μπορούσε να αποδοθεί ως «λογισμικό πολέμου». Μετάφραση-Επιμέλεια: Ερρίκος Φινάλης.

Παραπομπές

[1] ‘Lavender’: The AI machine directing Israel’s bombing spree in Gaza («“Λεβάντα”: Η μηχανή τεχνητής νοημοσύνης που κατευθύνει το όργιο βομβαρδισμών του Ισραήλ στη Γάζα»), Yuval Abraham (www.972mag.com, 3/4/2024).

[2] Blurring boundaries: an analysis of the digital platforms-military nexus («Θολώνοντας τα όρια: Ανάλυση της σχέσης ψηφιακών πλατφορμών-στρατιωτικού τομέα») στο GLO Discussion Paper Series, αριθ. 1364 (econpapers.repec.org).

[3] L’incubatore ucraino che sviluppa tecnologie belliche («Η ουκρανική θερμοκοιτίδα που αναπτύσσει πολεμικές τεχνολογίες»), Flavio Pintarelli (www.guerredirete.it, 13/3/2024).

Το δικαίωμα εναντίωσης

► Ποιος μπορεί να αντιταχθεί σε αυτήν την αυξανόμενη στρατιωτικοποίηση της ψηφιακής παραγωγής και στην αυξανόμενη πολεμική διαστρέβλωση των συστημάτων που βασίζονται στην τεχνητή νοημοσύνη; Σίγουρα το προσπαθούν οι φοιτητές στα ιταλικά πανεπιστήμια, που αγωνίζονται για την αναστολή της συνεργασίας των πανεπιστημίων τους με ισραηλινές στρατιωτικές εταιρείες. Το Τορίνο, η Πίζα και η Ρώμη είναι μερικά από τα πεδία αυτής της απλόχερης κινητοποίησης, που αντιστέκεται έξυπνα στις προσπάθειες της κυβέρνησης να καταστήσει ζήτημα δημόσιας τάξης αυτόν τον αγώνα. Φοιτητές, ερευνητές και καθηγητές χρησιμοποιούν τον στόχο της διακοπής της συνεργασίας με τα ισραηλινά ερευνητικά κέντρα που εμπλέκονται άμεσα ή έμμεσα στον πόλεμο της Γάζας για να θέσουν ένα πολιτικό ζήτημα ευρύτερης εμβέλειας: αυτό του ασυμβίβαστου μεταξύ της αυτονομίας της έρευνας, και ιδίως αυτής που ασχολείται με τις ψηφιακές τεχνολογίες αιχμής, και της χρήσης της ψηφιακής τεχνολογίας στον πόλεμο, σε όλους τους πολέμους.

► Ποιος μπορεί να αντιταχθεί σε αυτήν την αυξανόμενη στρατιωτικοποίηση της ψηφιακής παραγωγής και στην αυξανόμενη πολεμική διαστρέβλωση των συστημάτων που βασίζονται στην τεχνητή νοημοσύνη; Σίγουρα το προσπαθούν οι φοιτητές στα ιταλικά πανεπιστήμια, που αγωνίζονται για την αναστολή της συνεργασίας των πανεπιστημίων τους με ισραηλινές στρατιωτικές εταιρείες. Το Τορίνο, η Πίζα και η Ρώμη είναι μερικά από τα πεδία αυτής της απλόχερης κινητοποίησης, που αντιστέκεται έξυπνα στις προσπάθειες της κυβέρνησης να καταστήσει ζήτημα δημόσιας τάξης αυτόν τον αγώνα. Φοιτητές, ερευνητές και καθηγητές χρησιμοποιούν τον στόχο της διακοπής της συνεργασίας με τα ισραηλινά ερευνητικά κέντρα που εμπλέκονται άμεσα ή έμμεσα στον πόλεμο της Γάζας για να θέσουν ένα πολιτικό ζήτημα ευρύτερης εμβέλειας: αυτό του ασυμβίβαστου μεταξύ της αυτονομίας της έρευνας, και ιδίως αυτής που ασχολείται με τις ψηφιακές τεχνολογίες αιχμής, και της χρήσης της ψηφιακής τεχνολογίας στον πόλεμο, σε όλους τους πολέμους.

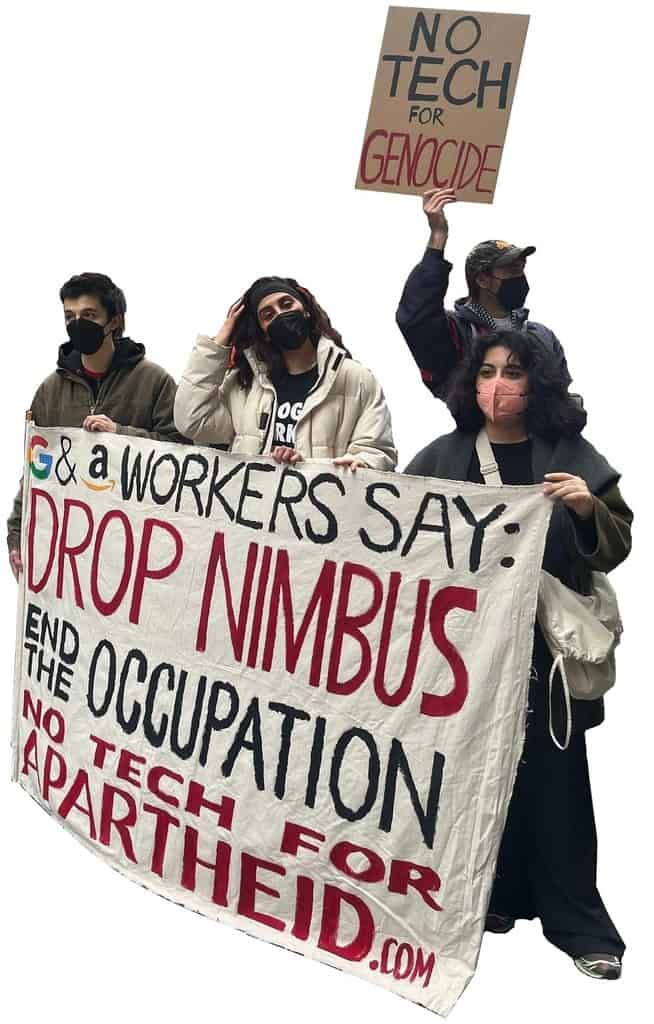

► Όπως ακριβώς προσπαθήσαμε να κάνουμε για τις πυρηνικές τεχνολογίες (με τις συνθήκες μη διάδοσης των πυρηνικών όπλων να αμφισβητούνται τώρα από τους δύο σημερινούς κύριους παίκτες της στρατιωτικής παραγωγής, τις ΗΠΑ και τη Ρωσία), έτσι πρέπει να πράξουμε και για τις τεχνολογίες τεχνητής νοημοσύνης – δηλαδή να προτείνουμε, όσο υπάρχει ακόμα χρόνος, τον «αφοπλισμό της τεχνητής νοημοσύνης». Εκτός όμως από τους φοιτητές, οι οποίοι θα πρέπει να υποστηριχθούν καλύτερα στους αγώνες τους για την αυτονομία της επιστήμης και της τεχνολογίας, οι άλλοι φορείς που μπορούν να αντιταχθούν στην υπαγωγή της ψηφιακής τεχνολογίας στον στρατό είναι οι εργαζόμενοι της μεγάλης τεχνολογίας, οι οποίοι αρχίζουν να εκδηλώνουν σαφείς εκφράσεις αμφισβήτησης.

► Το Time αναφέρει ότι στις 4/3/2024 σε ένα συνέδριο στο Μανχάταν, ενώ ο επικεφαλής της Google για το Ισραήλ προωθούσε την ισραηλινή βιομηχανία τεχνολογίας, ένας νεαρός σηκώθηκε όρθιος σε ένδειξη διαμαρτυρίας: «Είμαι μηχανικός λογισμικού του Google Cloud και αρνούμαι να κατασκευάσω τεχνολογία που τροφοδοτεί τη γενοκτονία, το απαρτχάιντ ή την επιτήρηση», φώναξε, φορώντας ένα πορτοκαλί μπλουζάκι με ένα ολόλευκο λογότυπο της Google. Ο εν λόγω εργαζόμενος της Google, ένας 23χρονος μηχανικός λογισμικού με το όνομα Έντι Χάτφιλντ, είναι μέλος μιας ομάδας διαμαρτυρίας με την ονομασία No Tech for Apartheid, η οποία καλεί την εταιρεία να εγκαταλείψει το πρόγραμμα Nimbus, ένα συμβόλαιο ύψους 1,2 δισεκατομμυρίων δολαρίων με το Ισραήλ, το οποίο η Google κατέχει από κοινού με την Amazon. Ο Χάτφιλντ οδηγήθηκε γρήγορα έξω από την αίθουσα συνεδριάσεων. Μετά από ένα διάλειμμα, ο επικεφαλής της Google σχολίασε στους παρευρισκόμενους αυτήν την πράξη διαμαρτυρίας ως εξής: «Ένα από τα προνόμια του να εργάζεσαι σε μια εταιρεία που εκπροσωπεί δημοκρατικές αξίες είναι να δίνεις χώρο σε διαφορετικές απόψεις». Τρεις ημέρες αργότερα, η Google απέλυσε τον Χάτφιλντ.